Hadoop - решение для больших данных

Рациональное использование полезной информации, скрытой за данными, может стать опасным препятствием для отраслей, игнорирование этой информации в конечном итоге замедлит рост вашей отрасли. Данные? Большое количество данных? Насколько вы думаете, насколько он большой, да, он действительно огромен по объему, с огромной скоростью, разнообразием, правдивостью и ценностью. Как вы думаете, как люди находят решение для работы с большими данными? Давайте обсудим эти различные подходы один за другим.

Традиционный подход

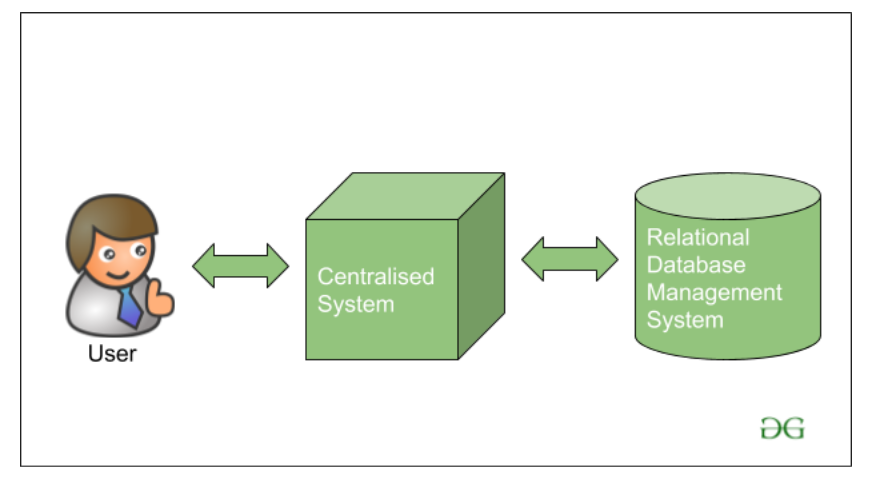

В традиционном подходе ранее технологическая компания Big Giant обрабатывала данные в единой системе, храня и обрабатывая данные с помощью различных поставщиков баз данных, доступных на рынке, таких как IBM, Oracle и т. Д. В базах данных, используемых в то время, использовалась СУБД (реляционная Система управления базами данных), который используется для хранения структурированных данных. Разработчик использует короткое приложение, которое помогает им общаться с базами данных и помогает им поддерживать, анализировать, изменять и визуализировать хранимые данные.

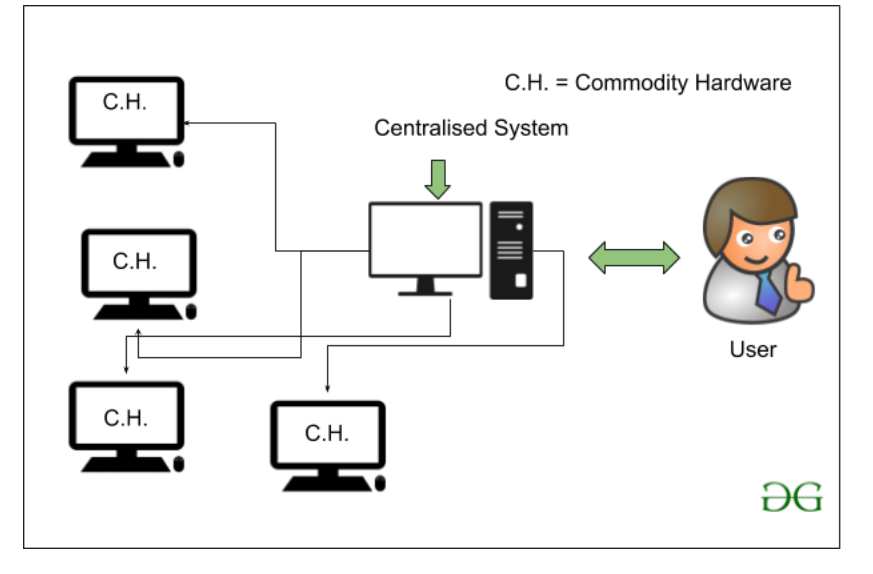

Но есть проблема с использованием этого традиционного подхода, проблема в том, что сервер базы данных в то время, который на самом деле является обычным оборудованием, способен только хранить и поддерживать данные очень небольшого размера. Данные могут обрабатываться только до предела, т.е. о скорости обработки процессоров, доступных в то время. Кроме того, серверы не очень эффективны и не способны обрабатывать скорость и разнообразие данных, потому что мы не используем кластер компьютерных систем. Один сервер базы данных предназначен для обработки всех этих данных.

Как Google находит решение для больших данных?

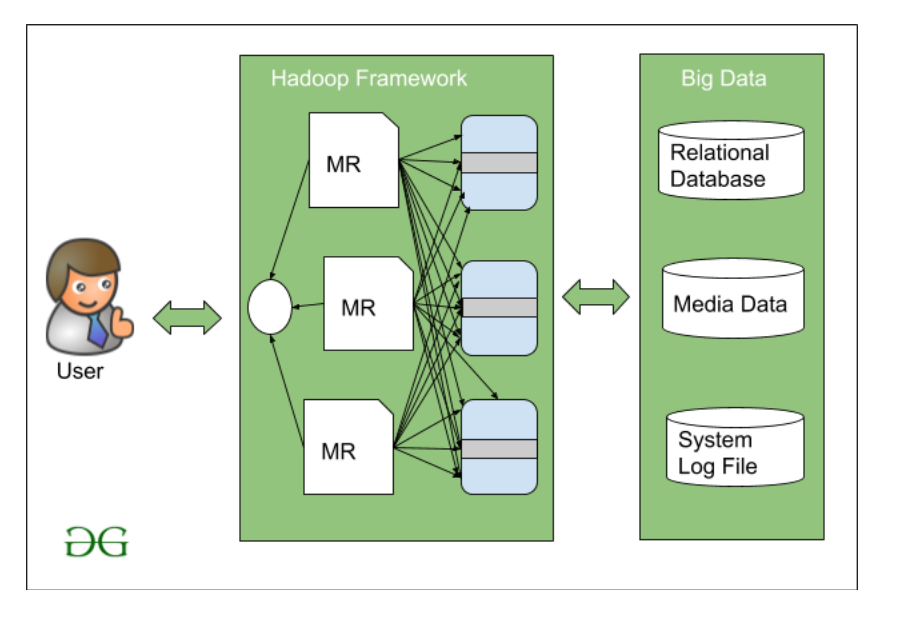

Google в то время представил алгоритм под названием MapReduce . MapReduce работает по архитектуре «главный-подчиненный». Это означает, что вместо того, чтобы выделять один сервер базы данных для обработки данных, Google ввел новую терминологию, в которой есть Мастер, который будет направлять другие подчиненные узлы для обработки этих больших данных. Задача должна быть разделена на различные блоки, а затем распределена между этими ведомыми устройствами. Затем, как только ведомые устройства обработают данные, ведущее устройство соберет результат, полученный от различных узлов ведомых устройств, и создаст окончательный набор данных результатов.

Позже Дуг Каттинг и его коллега Майк Кафарелла в 2005 году решили создать программное обеспечение с открытым исходным кодом, которое могло бы работать на этом алгоритме MapReduce. Здесь впервые представлена картина Hadoop для работы с очень большим набором данных.

Hadoop - это среда, написанная на Java, которая работает над набором различного простого товарного оборудования для работы с большим набором данных с использованием модели программирования самого базового уровня.