Недостаточное и переоснащение в машинном обучении

Допустим, мы разрабатываем модель машинного обучения. Модель считается хорошей моделью машинного обучения, если она должным образом обобщает любые новые входные данные из проблемной области. Это помогает нам делать прогнозы в отношении будущих данных, которых модель данных никогда не видела.

Теперь предположим, что мы хотим проверить, насколько хорошо наша модель машинного обучения обучается и обобщается на новые данные. Для этого у нас есть переобучение и недообучение, которые в значительной степени ответственны за низкую производительность алгоритмов машинного обучения.

Прежде чем продолжить погружение, давайте разберемся с двумя важными терминами:

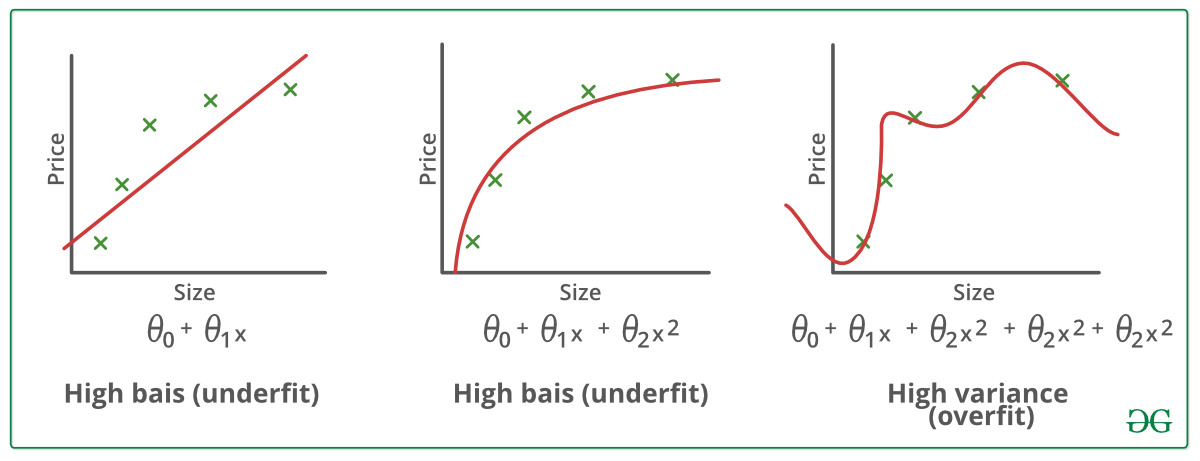

Смещение - допущения, сделанные моделью для облегчения изучения функции.

Дисперсия - если вы тренируете свои данные на данных обучения и получаете очень низкую ошибку, при изменении данных и последующем обучении той же предыдущей модели вы получаете высокую ошибку, это дисперсия.

Подоснащение:

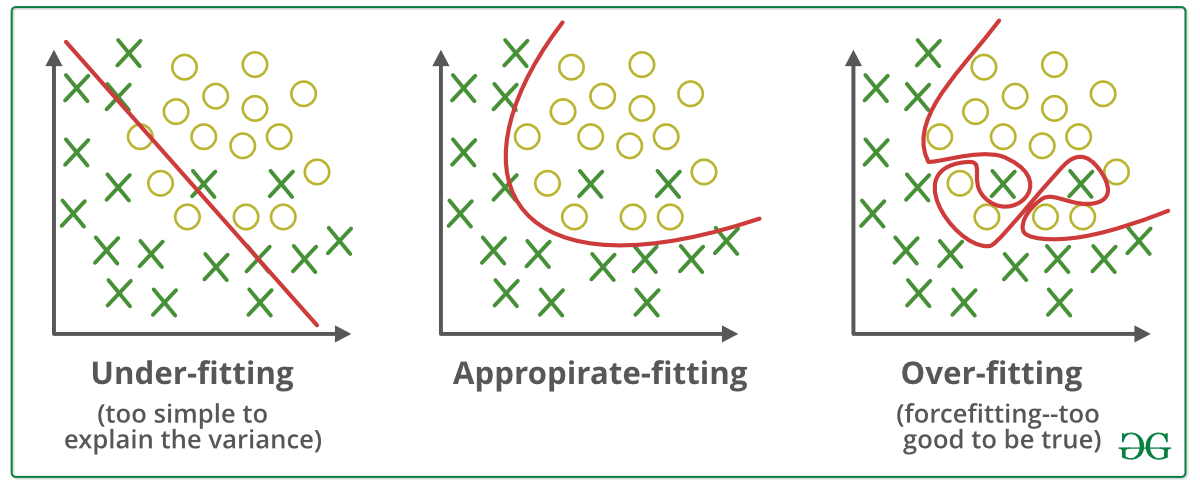

Считается, что статистическая модель или алгоритм машинного обучения не подходят, если не могут уловить основную тенденцию данных. (Это все равно, что пытаться подогнать брюки меньшего размера!) Недостаточная посадка снижает точность нашей модели машинного обучения. Его появление просто означает, что наша модель или алгоритм недостаточно хорошо соответствуют данным. Обычно это происходит, когда у нас меньше данных для построения точной модели, а также когда мы пытаемся построить линейную модель с нелинейными данными. В таких случаях правила модели машинного обучения слишком просты и гибки, чтобы их можно было применять к таким минимальным данным, и поэтому модель, вероятно, будет делать много неверных прогнозов. Недостаточного соответствия можно избежать, используя больше данных, а также сокращая количество функций путем выбора функций.

Вкратце, недостаточное соответствие - высокая систематическая ошибка и низкая дисперсия.

Методы уменьшения недообучения:

1. Увеличьте сложность модели.

2. Увеличьте количество функций, выполняя разработку функций

3. Убрать шум из данных.

4. Увеличивайте количество эпох или увеличивайте продолжительность обучения, чтобы получить лучшие результаты.

Переоснащение:

Считается, что статистическая модель переоснащена, если мы тренируем ее с большим количеством данных (как будто мы надеваем большие штаны!) . Когда модель обучается с таким большим количеством данных, она начинает учиться на шуме и неточных данных в нашем наборе данных. Затем модель неправильно классифицирует данные из-за слишком большого количества деталей и шума. Причины переобучения - непараметрические и нелинейные методы, потому что эти типы алгоритмов машинного обучения имеют больше свободы при построении модели на основе набора данных, и поэтому они действительно могут создавать нереалистичные модели. Чтобы избежать переобучения, можно использовать линейный алгоритм, если у нас есть линейные данные, или такие параметры, как максимальная глубина, если мы используем деревья решений.

Короче говоря, переоснащение - высокая дисперсия и низкий уровень смещения.

Примеры:

Методы уменьшения переобучения:

1. Увеличьте тренировочные данные.

2. Уменьшите сложность модели.

3. Раннее прекращение во время фазы тренировки (обратите внимание на потери в течение периода обучения, как только потери начинают увеличиваться, прекратите тренировку).

4. Регуляризация хребта и регуляризация лассо.

5. Используйте отсев для нейронных сетей, чтобы справиться с переобучением.

Хорошо вписывается в статистическую модель:

В идеале говорят, что случай, когда модель делает прогнозы с ошибкой 0, хорошо соответствует данным. Эта ситуация достижима в промежутке между переоборудованием и недостаточным оснащением. Чтобы понять это, нам нужно будет посмотреть на производительность нашей модели с течением времени, пока она учится на обучающем наборе данных.

С течением времени наша модель будет продолжать обучение, и, таким образом, ошибка модели в данных обучения и тестирования будет продолжать уменьшаться. Если она будет учиться слишком долго, модель станет более склонной к переобучению из-за наличия шума и менее полезных деталей. Следовательно, производительность нашей модели снизится. Чтобы получить хорошее соответствие, мы остановимся на точке непосредственно перед тем, как ошибка начнет увеличиваться. На данный момент считается, что модель имеет хорошие навыки работы с наборами обучающих данных, а также с нашим невидимым набором данных для тестирования.

Справка:

lasseschultebraucks.com/overfitting-underfitting-ml/

chunml.github.io/ChunML.github.io/tutorial/Underfit-Overfit/