Как установить Hadoop в кластер с одним узлом в Windows?

Hadoop можно установить двумя способами. Первый - в кластере с одним узлом, а второй - в кластере с несколькими узлами. Давайте посмотрим на объяснение их обоих. Но в этом разделе мы рассмотрим установку в кластере с одним узлом. Обсудим по порядку.

Кластер с одним узлом и кластер с несколькими узлами:

- Кластер с одним узлом - в нем работает один узел данных, который настраивает все NameNode, DataNode, Resource Manager и NodeManager на одном компьютере. Это используется для изучения и тестирования.

Кластер с несколькими узлами - имеет более одного запущенного DataNode, и каждый DataNode работает на разных машинах.

Этапы установки в кластере с одним узлом

Шаги по установке Hadoop с одним узлом кластера в Windows следующие.

Предпосылка:

- JAVA-Java JDK (установлен)

- Пакет HADOOP-Hadoop (загружен)

Шаг 1. Убедитесь, что Java установлена.

javac -version

Шаг 2. Распакуйте Hadoop в C: Hadoop

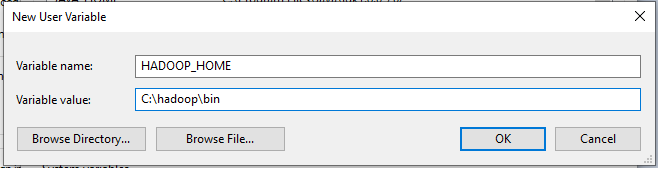

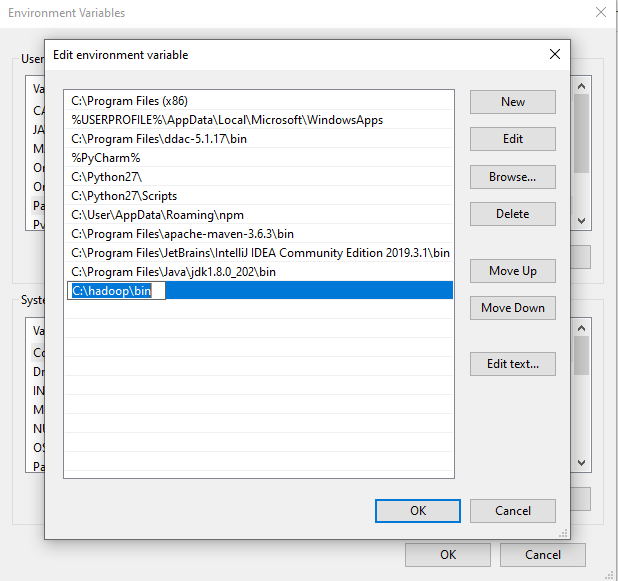

Шаг 3: Настройка переменной HADOOP_HOME

Используйте параметр переменной среды Windows для настройки пути Hadoop.

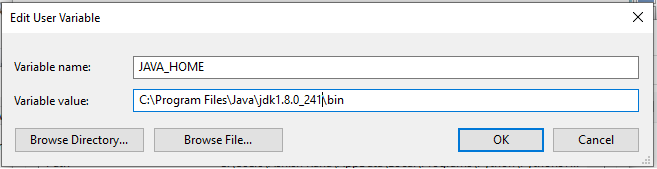

Шаг 4: установите переменную JAVA_HOME

Используйте параметр переменной среды Windows для настройки пути Hadoop.

Шаг 5. Задайте путь к каталогу bin Hadoop и Java

Шаг 6: Конфигурация Hadoop:

Для конфигурации Hadoop нам нужно изменить шесть файлов, которые перечислены ниже:

1. Core-site.xml 2. Mapred-site.xml 3. Hdfs-site.xml 4. Пряжа-site.xml 5. Hadoop-env.cmd 6. Создайте две папки datanode и namenode.

Шаг 6.1: Конфигурация Core-site.xml

<конфигурация>

<собственность>

<name> fs.defaultFS </name>

<value> hdfs: // локальный хост: 9000 </value>

</property>

</configuration>Шаг 6.2: Конфигурация Mapred-site.xml

<конфигурация>

<собственность>

<name> mapreduce.framework.name </name>

<value> пряжа </value>

</property>

</configuration>Шаг 6.3: Конфигурация Hdfs-site.xml

<конфигурация>

<собственность>

<name> dfs.replication </name>

<value> 1 </value>

</property>

<собственность>

<имя> dfs.namenode.name.dir </name>

<значение> C: hadoop-2.8.0 data namenode </value>

</property>

<собственность>

<name> dfs.datanode.data.dir </name>

<значение> C: hadoop-2.8.0 data datanode </value>

</property>

</configuration>Шаг 6.4: Конфигурация Yarn-site.xml

<конфигурация>

<собственность>

<name> yarn.nodemanager.aux-services </name>

<value> mapreduce_shuffle </value>

</property>

<собственность>

<name> yarn.nodemanager.auxservices.mapreduce.shuffle.class </name>

<value> org.apache.hadoop.mapred.ShuffleHandler </value>

</property>

</configuration>Шаг 6.5: конфигурация Hadoop-env.cmd

Установите "JAVA_HOME = C: Java" (на C: java это путь к файлу jdk.18.0)

Шаг 6.6: Создайте папки datanode и namenode

1. Создайте папку «data» в «C: Hadoop-2.8.0». 2. Создайте папку «datanode» в «C: Hadoop-2.8.0 data». 3. Создайте папку «namenode» в «C: Hadoop-2.8.0 data».

Шаг 7. Отформатируйте папку namenode

Откройте командное окно (cmd) и введите команду «hdfs namenode –format».

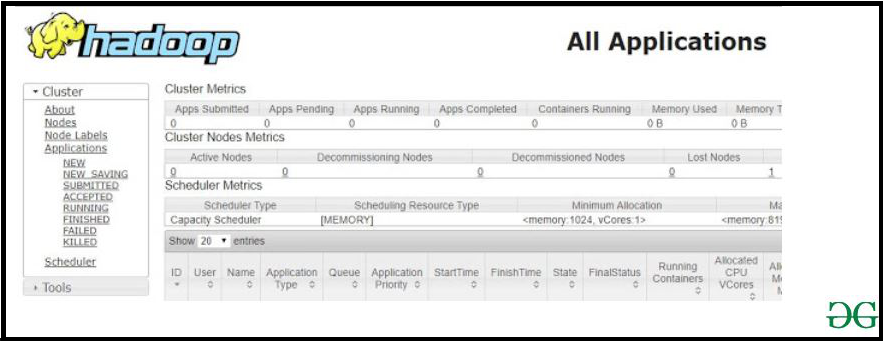

Шаг 8: Тестирование настройки

Откройте командное окно (cmd) и введите команду «start-all.cmd».

Шаг 8.1: Тестирование настройки:

Убедитесь, что namenode, datanode и диспетчер ресурсов запущены.

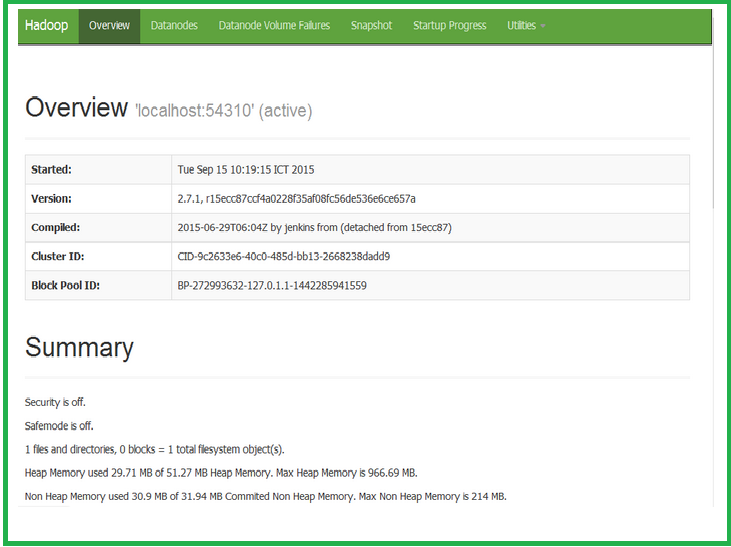

Шаг 9: Откройте: http: // localhost: 8088

Шаг 10:

Открыть: http: // localhost: 50070