Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 2)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 3)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 4)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 6)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 7)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 8)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 10)

Введение

System Center Virtual Manager — это комплексный продукт для управления центром обработки данных. SCVMM был разработан для обработки почти всех аспектов ИТ-центра обработки данных. Вы можете определить физические сетевые компоненты в SCVMM с помощью VM Networks. SCVMM также позволяет управлять хранилищем SAN и кластерами файловых серверов. В первой части этой серии статей объяснялись требования к группе узлов VMM и узлам Hyper-V, прежде чем вы сможете создать кластер Hyper-V с помощью VMM. Во второй части объясняются требования к общему хранилищу и сети.

Требования к общему хранилищу Hyper-V

Поскольку для кластера Hyper-V требуется общее хранилище, необходимо, чтобы требование к общему хранилищу было выполнено, прежде чем вы продолжите создание кластера Hyper-V. VMM позволяет подключаться к iSCSI и Fibre Channel SANS и управлять этими массивами хранения с помощью VMM. Пулы хранения из массивов хранения могут использоваться узлами Hyper-V, управляемыми VMM. Например, вы можете назначать пулы хранения при создании частного облака, при развертывании виртуальных машин на хосте и при развертывании кластера Hyper-V. Существует два способа выделения общего хранилища узлам Hyper-V перед запуском мастера создания кластера Hyper-V:

Общее хранилище, управляемое и выделяемое SCVMM. Если вы хотите использовать общее хранилище, которым управляет SCVMM, имейте в виду следующее:

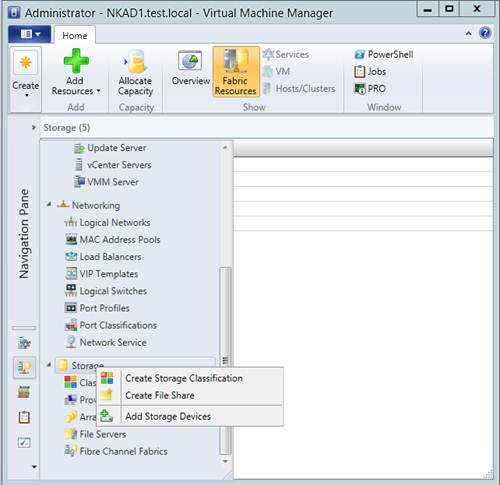

- Требуемые общие массивы хранения должны быть обнаружены и классифицированы в рабочей области Fabric. Если вы этого не сделали, перейдите в рабочую область Fabric, щелкните правой кнопкой мыши узел «Хранилище», а затем нажмите «Добавить устройства хранения», как показано на рисунке ниже:

фигура 1

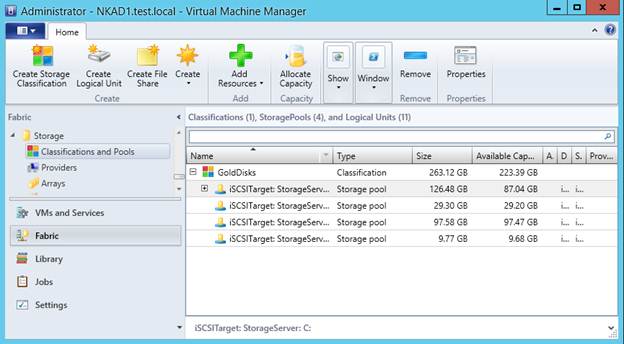

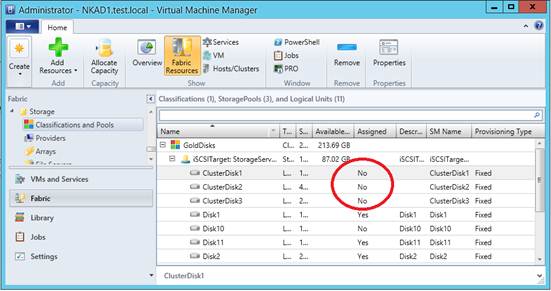

- Если вы используете iSCSI SAN или Windows iSCSI Target, убедитесь, что служба инициатора iSCSI установлена и запущена на узле VMM. Это необходимо для успешного создания подключения к серверу iSCSI SAN из консоли VMM. В этой статье мы используем цель Windows iSCSI, установленную на сервере Windows Server 2012 R2. После добавления массива хранения в VMM вы увидите все доступные пулы хранения, щелкнув узел «Классификации и пулы» в рабочей области Fabric, как показано на рисунке ниже:

фигура 2

Примечание:

Целевой сервер Windows iSCSI проверяет все локальные диски и добавляет их в пулы хранения. В этом случае у меня есть четыре локальных диска, созданных на сервере хранения, и каждый диск считается пулом хранения. Вы также можете увидеть размер каждого пула хранения и доступное пространство.

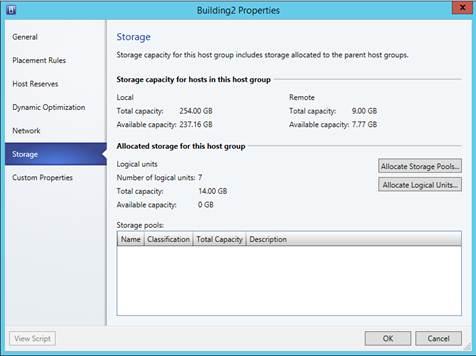

- Логические единицы были созданы и распределены по группе узлов, в которой находятся узлы Hyper-V. Давайте проясним этот момент. Пулы носителей и логические единицы можно выделять только в группе узлов VMM. Выделенные пулы носителей могут использоваться VMM только для размещения виртуальных машин. Выделенные логические единицы используются как кластером, так и виртуальными машинами. Нет необходимости выделять пулы носителей, но вы должны выделить логические единицы в свойстве группы узлов VMM, если хотите, чтобы мастер создания кластера отображал доступные логические единицы. Мастер создания кластера будет искать логические единицы, а не пулы хранения, которые вы выделили группе узлов VMM. Перед выделением логических блоков убедитесь, что вы создали их с помощью ленты «Создать логические блоки» в рабочей области Fabric. После создания логических единиц щелкните правой кнопкой мыши группу узлов VMM, в которой находятся узлы Hyper-v, и нажмите «Выделить логические единицы», как показано на рисунке ниже:

Рисунок 3

Примечание:

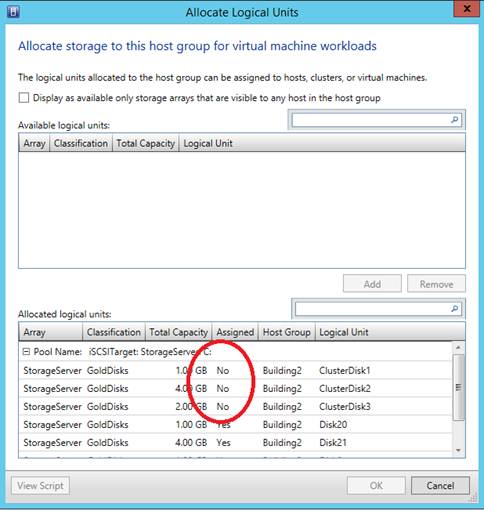

Логические блоки, которые вы создаете из общего пула хранения, не должны назначаться ни одному хосту Hyper-V. Мастер создания кластера Hyper-V в VMM может обнаруживать только те логические устройства, которые не назначены ни одному из узлов Hyper-V в VMM. Как вы можете видеть, на рисунке ниже есть несколько логических единиц, выделенных для группы узлов VMM, но лишь немногие из них зарезервированы для создания кластера.

Рисунок 4

Вы также можете подтвердить в рабочей области Fabric, чтобы убедиться, что логические единицы, используемые для кластера Hyper-V, не назначены ни одному из хостов Hyper-V, перейдя к узлу «Классификации и пулы», как показано на рисунке ниже:

Рисунок 5

Хосты, управляемые общим хранилищем: если вы хотите использовать общее хранилище, которым управляют хосты Hyper-V, вы должны убедиться, что логические единицы были созданы на одном из хостов Hyper-V и отформатированы с использованием раздела NTFS. Это традиционный подход, которому следует следовать при построении кластера Hyper-V с помощью диспетчера отказоустойчивого кластера. В этом случае общее хранилище должно быть назначено и доступно на всех узлах Hyper-V, прежде чем вы запустите мастер создания кластера Hyper-V через VMM.

Требования к сети хостов Hyper-V

Для отказоустойчивой кластеризации необходимо добавить необходимые сетевые адаптеры на каждый узел Hyper-V. Помимо добавления сетевых адаптеров, вы также должны понимать, как VMM будет обрабатывать сеть на хостах Hyper-V при создании кластера Hyper-V через VMM. Мастер создания кластера Hyper-V также предоставляет возможность назначить IP-адрес кластеру помимо назначения имени кластера. Страница IP-адреса может отображаться или не отображаться в зависимости от следующих условий:

- Если вы используете статическую IP-конфигурацию на каждом узле Hyper-V, убедитесь, что по крайней мере один физический сетевой адаптер на всех узлах Hyper-V принадлежит к одной и той же IP-подсети. Физические сетевые адаптеры также должны быть настроены с использованием шлюза по умолчанию, чтобы страница IP-адреса отображалась во время создания кластера.

- Если вы настроили узлы Hyper-V для получения IP-конфигурации от DHCP-сервера, что не рекомендуется в производственной среде, мастер создания кластера не предоставит вам возможность назначить IP-адрес кластеру. Другими словами, страница IP-адреса отображаться не будет. Поскольку операционные системы Windows Server 2012 и более поздних версий поддерживают назначение IP-адреса кластера с DHCP-сервера, мастер создания кластера автоматически выберет доступный IP-адрес с DHCP-сервера, а не покажет вам страницу IP-адреса.

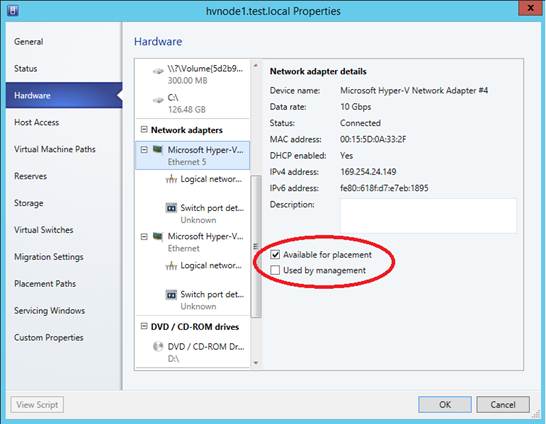

Какой бы метод вы ни использовали для назначения IP-адресов сетевым адаптерам узла Hyper-V, убедитесь, что эти сетевые адаптеры доступны для размещения. Чтобы убедиться, что сетевые адаптеры доступны для размещения, перейдите к свойствам всех хостов Hyper-V, нажмите кнопку «Сеть», а затем щелкните сетевую карту, чтобы увидеть настройку, как показано на рисунке ниже, взятом с хоста Hyper-V.:

Рисунок 6

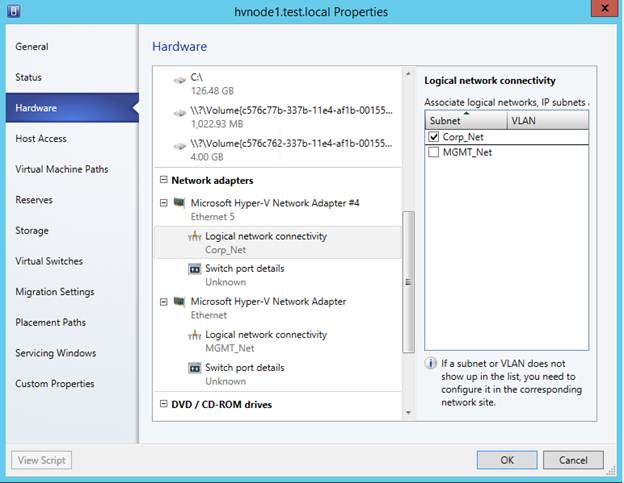

Виртуальный коммутатор: Мастер создания кластера Hyper-V позволяет автоматически создать виртуальный коммутатор на каждом хосте Hyper-V. Нет необходимости создавать виртуальные коммутаторы во время работы мастера создания кластера. Вы также можете заранее создать виртуальные коммутаторы на каждом узле Hyper-V, но создание виртуальных коммутаторов с помощью VMM обеспечивает согласованность и идентичность конфигурации. Прежде чем на странице виртуального коммутатора можно будет отобразить сети виртуальных машин, необходимо убедиться, что физические сетевые адаптеры назначены для использования сети виртуальных машин в свойстве узла Hyper-V. Чтобы убедиться, что сети виртуальных машин назначены хосту Hyper-V, перейдите к свойствам каждого хоста Hyper-V, нажмите кнопку «Оборудование», а затем щелкните физический сетевой адаптер, как показано на рисунке ниже.

Рисунок 7

Как вы можете видеть на рисунке выше, физический сетевой адаптер связан с логической сетью «Corp_Net», которая является моей тестовой лабораторией. Если физический сетевой адаптер не связан ни с одной из логических сетей, страница «Виртуальный коммутатор» не позволит вам автоматически создать виртуальный коммутатор на узлах Hyper-V.

Резюме

Вы можете увидеть, насколько это сложно, прежде чем запустить мастер создания кластера Hyper-V через VMM. В этой статье объясняется, как настроить общее хранилище и сеть, чтобы мы могли успешно развернуть отказоустойчивый кластер Hyper-V через VMM. В следующей части этой серии я познакомлю вас с мастером создания кластера Hyper-V.

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 3)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 4)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 6)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 7)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 8)

- Как успешно создать кластер Hyper-V с помощью диспетчера виртуальных машин (часть 10)