Введение в уменьшение размерности

Машинное обучение: как уже говорилось в этой статье, машинное обучение - это не что иное, как область исследований, которая позволяет компьютерам «учиться», как люди, без необходимости явного программирования.

Что такое прогнозное моделирование: прогнозное моделирование - это вероятностный процесс, который позволяет нам прогнозировать результаты на основе некоторых предикторов. Эти предикторы в основном являются характеристиками, которые используются при принятии решения об окончательном результате, то есть исходе модели.

Что такое уменьшение размерности?

В задачах классификации машинного обучения часто бывает слишком много факторов, на основе которых делается окончательная классификация. Эти факторы в основном являются переменными, называемыми функциями. Чем выше количество функций, тем сложнее визуализировать обучающий набор, а затем работать над ним. Иногда большинство этих функций коррелированы и, следовательно, являются избыточными. Здесь в игру вступают алгоритмы уменьшения размерности. Снижение размерности - это процесс уменьшения количества рассматриваемых случайных величин путем получения набора основных переменных. Его можно разделить на выбор признаков и извлечение признаков.

Почему уменьшение размерности важно в машинном обучении и прогнозном моделировании?

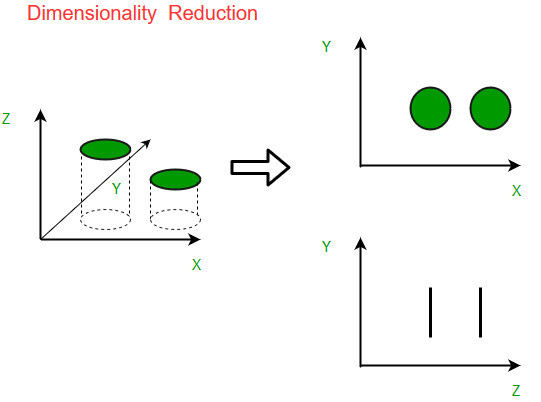

Интуитивно понятный пример уменьшения размерности можно обсудить с помощью простой задачи классификации электронной почты, когда нам нужно классифицировать, является ли электронное письмо спамом или нет. Это может включать в себя большое количество функций, например, имеет ли электронное письмо общий заголовок, содержание электронного письма, использует ли электронное письмо шаблон и т. Д. Однако некоторые из этих функций могут перекрываться. . В другом случае проблема классификации, которая зависит как от влажности, так и от дождя, может быть сведена к одному основному признаку, поскольку оба вышеупомянутых элемента в высокой степени коррелированы. Следовательно, мы можем уменьшить количество функций в таких задачах. Проблема трехмерной классификации может быть трудной для визуализации, тогда как двумерная задача может быть отображена в простое двухмерное пространство, а одномерная задача - в простую линию. На рисунке ниже показана эта концепция, где трехмерное пространство признаков разделено на два одномерных пространства признаков, а позже, если будет обнаружено, что они коррелированы, количество объектов может быть уменьшено еще больше.

Компоненты уменьшения размерности

Есть два компонента уменьшения размерности:

- Выбор функций: здесь мы пытаемся найти подмножество исходного набора переменных или функций, чтобы получить меньшее подмножество, которое можно использовать для моделирования проблемы. Обычно это происходит тремя способами:

- Фильтр

- Обертка

- Встроенный

- Извлечение признаков: это уменьшает данные в пространстве большой размерности до пространства меньшей размерности, т. Е. Пространства с меньшим номером. размеров.

Методы уменьшения размерности.

Различные методы, используемые для уменьшения размерности, включают:

- Анализ главных компонентов (PCA)

- Линейный дискриминантный анализ (LDA)

- Обобщенный дискриминантный анализ (GDA)

Снижение размерности может быть как линейным, так и нелинейным, в зависимости от используемого метода. Основной линейный метод, называемый анализом главных компонентов, или PCA, обсуждается ниже.

Анализ главных компонентов

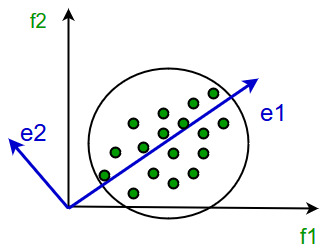

Этот метод был введен Карлом Пирсоном. Он работает при условии, что в то время как данные в пространстве более высокого измерения отображаются на данные в пространстве более низкого измерения, дисперсия данных в пространстве более низкого измерения должна быть максимальной.

Он включает в себя следующие этапы:

- Постройте ковариационную матрицу данных.

- Вычислите собственные векторы этой матрицы.

- Собственные векторы, соответствующие наибольшим собственным значениям, используются для восстановления большой доли дисперсии исходных данных.

Следовательно, у нас остается меньшее количество собственных векторов, и в процессе могла быть некоторая потеря данных. Но наиболее важные отклонения должны сохраняться оставшимися собственными векторами.

Преимущества уменьшения размерности

- Это помогает в сжатии данных и, следовательно, уменьшает пространство для хранения.

- Это сокращает время вычислений.

- Это также помогает удалить избыточные функции, если таковые имеются.

Недостатки уменьшения размерности

- Это может привести к потере некоторого количества данных.

- PCA имеет тенденцию находить линейные корреляции между переменными, что иногда нежелательно.

- PCA не работает в тех случаях, когда среднего и ковариации недостаточно для определения наборов данных.

- Мы можем не знать, сколько основных компонентов нужно сохранить на практике, применяются некоторые правила большого пальца.

Эта статья предоставлена Ананней Уберой . Если вам нравится GeeksforGeeks, и вы хотели бы внести свой вклад, вы также можете написать статью с помощью provide.geeksforgeeks.org или отправить ее по электронной почте на deposit@geeksforgeeks.org. Посмотрите, как ваша статья появляется на главной странице GeeksforGeeks, и помогите другим гикам.

Пожалуйста, напишите комментарии, если вы обнаружите что-то неправильное, или вы хотите поделиться дополнительной информацией по теме, обсужденной выше.